در بررسی تاریخچه کارت گرافیکهای خود به بازه 2013 تاکنون (اوایل 2021) رسیدهایم. کمتر طرفدار و دنبال کننده صنعت سخت افزار است که با این بازه آشنایی کامل نداشته باشد، اما در این بازه نیز اتفاقات جالبی برای شرکتهای سازنده کارت گرافیک و همچنین اهداف و قلمرو کارت گرافیکها رخ داده است که مطالعه در مورد آن خالی از لطف نیست. در این بازه همچنین شیوع ویروس همه گیر کرونا و ایجاد یک بحران جهانی را داریم که تاثیر بسیار شدیدی بر روی بازار سخت افزار و تولید محصولات مربوط به آن گذاشت و یکی از تاریکترین بازههای این صنعت را برای طرفدارن رقم زد. برای بررسی عمیقتر این بازه با اگزوگیم همراه باشید.

در چهارمین قسمت از تاریخچه پردازندههای گرافیکی مدرن، به نقطهای رسیده بودیم که بازار از سه رقیب AMD، Intel و Nvidia تشکیل شده بود. تا سال 2013، همه مسیر مشابهی را برای طراحی معماری خود دنبال میکردند و همه رایانههای شخصی و ایستگاههای کاری را هدف قرار میدادند. این امر به دلیل جهت گیری رندر، الزامات تعیین شده توسط APIهای گرافیکی، و کاربرد گستردهتر GPU ها در محاسبات و هوش مصنوعی تعیین شده بود. اما مسیر جدیدی در انتظار حافظههای گرافیکی بود.

با این حال، در سالهای بعد، پردازندههای گرافیکی به یکی از بزرگترین، پیچیدهترین و گرانترین اجزایی تبدیل شدند که تقریباً در هر دستگاه محاسباتی یافت میشد.

در سال 2014 ما شاهد معماریهای جدیدی بودیم که توسط اکثر فروشندگان اصلی منتشر شد و همچنین تعداد زیادی از محصولات با استفاده از فناوریهای قدیمیتر که در بازار قرار گرفته بودند. در مورد AMD، خط تولید آنها تقریباً از سیستمهای قبلی تشکیل شده بود و همان سبک سنتی خود را حفظ کرده بودند. در بازار دسکتاپ، مدلهایی با استفاده از Graphics Core Next (GCN) 1.0 و معماری حتی قدیمیتر TeraScale 2 برای کاربران و علاقه مندان عرضه شد. نمونه خوب اولی Radeon R9 280 بود که در ماه مارس عرضه شد و توانست کم و بیش نظرات را به سمت خود جلب کند.

این کارت گرافیک در واقع همان کارت Radeon HD 7950 عرضه شده در 2 سال پیش بود که تغییر نام تجاری برای آن صورت گرفته بود، اما حداقل AMD این حس را داشت که آن را با قیمت کمتری نسبت به اولین نسخه خود عرضه کند. اندکی پس از آن محصول، Radeon R9 295X مجهز به GCN 2.0 ظاهر شد و کاملاً روندی متفاوت با 280 را در پیش گرفته بود.

با داشتن دو پردازنده گرافیکی، سیستم خنککننده سفارشی و قیمت 1499 دلاری، مستقیماً به بالای جدول عملکرد پرید و مصرف کنندگان و اهالی صنعت سخت افزار از خوب بودن آن (با وجود هزینههای سرسامآور) شگفتزده شدند.

در سپتامبر 2014، شرکت سرخ کارت گرافیک Radeon R9 285 را منتشر کرد، این کارت دارای یک تراشه جدید بود که معماری GCN خود را بهروزرسانی میکرد، که پیشرفتهای جزئی را در سیستمهای حافظه پنهان و Tessellation به ارمغان آورد. این کارت قدرتمند و خوش ساخت با قیمت 250 دلار، جایگزین R9 280 قدیمی شد و با کلاکهای بالاتری نسبت به این نسخه عرضه شد. اگرچه به دلیل داشتن 25 درصد پهنای باند حافظه کمتر، سرعت آن تنها اندکی بیشتر بود.

ممکن است عجیب به نظر برسد که AMD پیشرفت کمی با GCN 3.0 نسبت به نسخه قبلی آن داشته است، اما در آن زمان، آنها با بدهیهای بزرگ و سطوح ضعیف درآمد عملیاتی دست و پنجه نرم میکردند. برای مبارزه با این مشکل، آنها بر بازارهای سودآورتر، مانند سیستمهای کم قدرت و طراحیهای نیمه سفارشی تمرکز کردند. این تصمیم یکی از بزرگترین تاثیرات را بر روی اینده نزدیک این شرکت و همچنین بازار کارت گرافیکها گذاشت.

در مقابل، شرایط اقتصادی و سوددهی انویدیا در آن سال تا حد زیادی پررونق بود. آنها علیرغم برخی تصمیمات عجیب و غریب در مورد محصولات خود، هم در درآمد و هم در درآمد خالص به سود ثابتی دست یافتند. مانند AMD، آنها از سیستمهای قدیمیتر، بهروزرسانیشده و معماری جدید (Maxwell) استفاده کردند که در مورد دومی، این مدل در یک مدل رده بالا و سفارشی استفاده نشد، اما در عوض در قیمت 150 دلاری و برای حکمرانی بر بخش میان رده بازار کارت گرافیک عرضه شد.

کارت گرافیک GeForce GTX 750 Ti برای رقابت با کارتهایی مانند Radeon R7 265 از شرکت AMD طراحی شده بود. این کارت علیرغم فناوری جدید خود، در اکثر موارد و بازیها به سرعت Radeon جدید نمیرسید. اگر این همه چیزی میبود که انویدیا در فوریه 2014 ارائه میکرد، ممکن بود تصور شود که آنها در حال از دست دادن شتاب اقتصادی و پیشرفت خود هستند.

این امر به این دلیل تشدید شد که انویدیا بدون هیاهو، جدیدترین عضو از بهترین خط تولید برای کارتهای عرضه شده توسط خود تا به آن زمان یعنی GeForce GTX Titan را با افزودن کلمه "Black" و سرعت کلاک کمی بالاتر به روز با 999 دلار به روز کرد. نسخه جدید گرانتر از نسخه نسل قبلی این سری نبود، اما به دلیل تبلیغ کم انویدیا به سختی تیتر خبرها بود.

برای مبارزه با عرضه Radeon R9 295X2 توسط AMD در ماه آوریل، انویدیا Titan Z را در ماه بعد معرفی کرد. این کارت گرافیک به معنای واقعی کلمه برای نشان دادن قدرت انویدیا در تولید کارتی با عملکرد بسیار بالا در آن سال بود و نمیشد به چشم کارتی برای بازار به آن نگاه کرد اما در هر حال توانست نظرات و توجهات را به خود جلب کند.

در واقع تعداد بسیار کمی نمونه برای تجزیه و تحلیل در اختیار منتقدان سخت افزار قرار گرفت، و هیچکدام نیز حاضر به پرداخت 2999 دلار قیمت درخواستی برای این کارت گرافیک نشدند. برای تعداد معدودی که موفق به آزمایش آن شدند، عملکرد کلی برای چنین محصول گران قیمتی کمتر از حد ایده آل آن هم برای 2999 دلار بود، به طور کلی بدتر از R9 295X2 و دو کارت قدیمی GeForce GTX 780 Ti انویدیا در حالت SLI.

در سپتامبر، زمانی که سری GeForce GTX 900 وارد فروشگاهها شد، شرایط برای انویدیا بسیار بهبود یافت، حتی با وجود اینکه تنها دو مدل از این سری موجود بود.

کارت گرافیکهای جذاب و خوش ساخت GeForce GTX 980 و 970 از تراشههای مبتنی بر Maxwell استفاده میکردند، البته با تغییرات جزئی، و سرفصلهای بسیاری از تیترها را به خود اختصاص دادند. اولین موردی که همگان در مورد آن صحبت میکردند مربوط به قیمتها بود: مدلهای جدید به ترتیب با قیمت 529 و 329 دلار هر دو ارزانتر از GTX 780 و 770 در زمان عرضه بودند. عملکرد دو کارت نسبت به قیمت و رقیب خوب بود و در مقابل نسخههای عرضه شده توسط AMD و کاتالوگ پشتیبان انویدیا قابل رقابت بودند.

در مجموع، باید در عمل پایان سال موفقیت آمیزی برای انویدیا میبود، اما GTX 970 «ویژگی» را پنهان میکرد که به سرعت تمام نقطه نظرات خوبی را که راه اندازی سری جدید به همراه داشت، از بین میبرد.

در برگه مشخصات این مدل آمده است که دارای 4 گیگابایت حافظه GDDR5 با سرعت 7 گیگابیت بر ثانیه در یک گذرگاه 256 بیتی مانند GTX 980 است. جزئیات به این ادعا مربوط میشود که GPU دارای 64 ROP است. (واحدهای خروجی رندر) و 2 مگابایت حافظه نهان L2.

با این حال، چیزی که انویدیا در مورد آن سکوت کرد این بود که این مشخصات کاملاً درست نبود، در عمل این کارت گرافیک فقط 56 ROP و 1.75 مگابایت حافظه نهان L2 داشت که به این معنی بود که گذرگاه حافظه باید فقط 224 بیتی و بنابراین فقط 3.5 گیگابایت رم میبود. . سوال مشخص بود، پس 0.5 گیگابایت دیگر کجا بود؟

نکته عجیب این است که این مقدار حافظه واقعاً آنجا بود، بنابراین "4 گیگابایت در یک گذرگاه 256 بیتی" واقعا وجود داشت، اما نه به همان روشی که در GTX 980 وجود داشت. به دلیل پیکربندی پورتهای crossbar و کنترل کنندههای حافظه، سیستم میتوانست به صورت موازی بخواند / بنویسد. در واقع این کار از طریق اتصال 224 بیتی به 3.5 گیگابایت یا از یک گذرگاه 32 بیتی از 0.5 گیگابایت باقی مانده استفاده میکرد.

با فاش شدن خبر این فریب ظاهری، انویدیا تلاش کرد تا وضعیت را توضیح دهد و دلیل آن را اشتباهات در انتشار اسناد خود برای مطبوعات دانست.

آنها توضیحی برای راه اندازی ارائه کردند و از اشتباه خود عذرخواهی کردند و اشاره کردند که پیکربندی ROP + حافظه در واقع مشکلی نبوده و کاملاً عمدی بوده است. اما به هر جهت آسیب به اعتبار شرکت وارد شد، و دو سال بعد، آنها مجبور شدند به بسیاری از اعتراضات دسته جمعی غرامت بدهند و 30 دلار را به تمام خریداران GTX 970 پیشنهاد کردند.

تکه سوم مثلث تراشههای گرافیکی یعنی اینتل نیز در سال 2014 یک معماری جدید با نام رمز Gen8 را به عنوان بخش اصلی از پردازندههای Broadwell خود منتشر کرد. در آن زمان پردازندههای گرافیکی یکپارچه تقریباً هرگز علاقهای را به خود جلب نمیکردند (همین حالا هم نظرات در مورد آنها متغیر و متناقض است)، علیرغم اینکه نسل جدید اینتل بخش قابل توجهی از پردازندههای مرکزی را تشکیل میدهند، اما طراحی نسبت به نسل قبلی خود پیشرفتهای قابلتوجهی را نشان میداد.

هر دو جفت پردازنده SIMD (تک دستورالعمل، دادههای متعدد) در EUs (واحدهای اجرا) اکنون میتوانند عملیات اعداد صحیح و ممیز شناور را مدیریت کنند، در حالی که قبلاً فقط یکی از این دو شدنی بود. دو برابر شدن مؤثر نرخ توان عملیاتی اعداد صحیح با ارائه پشتیبانی از فرمتهای داده FP16 دوباره با نرخ دو برابری مطابقت داشت.

این تغییرات باعث شد GPU های کوچک با قابلیتهای معماری تراشههای AMD و Nvidia ارتباط برقرار کنند. با این حال، کمبود EU، واحدهای بافت و ROP همچنان آنها را برای بازی نامناسب کرده بود.

نه اینکه پردازندههای گرافیکی کوچک قادر به اجرای بازیهایی با ظاهر مناسب نیستند بلکه قلمرو و هدف تولید آنها متفاوت بود و در نتیجه نیازی به اثبات توانایی و عملکرد خود در این بخش نداشتند.

در دنیای گوشیهای هوشمند، اپل آیفون 6 را در ماه سپتامبر عرضه کرد که توسط SoC A8 (سیستم روی یک تراشه) طراحی شده بود. این پردازنده از ساختارهای CPU و GPU لایسنس شده از Arm و PowerVR استفاده میکرد، اما دومی شامل برخی از واحدهای سفارشی ساخته شده توسط خود اپل نیز بود.

اپل در حال معرفی Metal API جدید خود بود. این مجموعه از کدها شامل گرافیک و شیدرهای محاسباتی بود که همگی به شدت برای پردازندههای گرافیکی آیفون و آی پد بهینه شده بودند. همانطور که توسعه دهندگان با گذشت زمان بیشتر با این نرم افزار آشنا شدند، به محصولات اپل برتری عملکردی متمایز نسبت به رقبا داد. برتری که همچنان نیز ادامه دارد.

نیاز به کنترل برنامهنویسی بهتر و کدهای کم تأخیر فقط به گوشیهای هوشمند محدود نمیشد. در پشت صحنه، گروه Khronos (کنسرسیومی از ارگانهای صنعتی) کار بر روی ایجاد جانشین OpenGL را آغاز کرد. در واقع هدف آن ارائه یک گرافیک بین پلتفرمی و API محاسباتی بر اساس کار AMD با نرمافزار Mantle بود.

و قرار بود این نرم افزار به یکی از ویژگیهای مهم سال بعد تبدیل شود.

یک کارت قدیمی، یک کارت جدید ... صبر کنید! دوباره همان کارت سال قبل؟

از بسیاری جهات، سال 2015 فقط تکرار سال قبل بود. AMD نزدیک به 30 کارت گرافیک مختلف را روانه بازار کرد که اکثریت آنها از معماری قدیمی GCN 1.0 یا 2.0 استفاده میکردند.

هرچند کهنه کار تراشههای سیلیکونی، رویکرد تفنگ ساچمهای را برای زمان بندی عرضه محصولات در پیش گرفت. در ماه ژوئن، از ظاهر Radeon R9 390X مجهز به GCN 2.0 (که اساساً یک GPU R9 295X2، با افزایش کلاک بود) و Radeon R9 Fury X کاملاً جدید رونمایی شد.

اگرچه 200 دلار تفاوت بین این دو وجود داشت، اما Fury گرانتر میتوانست این قیمت را توجیه کند. پردازنده گرافیکی 596 میلیمتر مربع، با اسم رمز Fiji، در 4096 واحد سایه زن که 45 درصد بیشتر از X390 بود، بستهبندی شده بود. همچنین این اولین کارت گرافیک در سطح مصرف کننده بود که از HBM (حافظه با پهنای باند بالا) استفاده کرد.

این فناوری شامل چیپهای DRAM روی هم چیده میشود و اتصالات از طریق آنها اجرا میشود. نتیجه نهایی یک سیستم بسیار فشرده تر است که پهنای باند حافظه زیادی را فراهم می کند، البته در مجموع بیش از 4 گیگابایت از آن برای اولین بار تکرار نمی شود.

اما همه آن واحد سایه زن و رمهای فانتزی جدید برای توسعه دهنده و مصرف کننده هزینهای داشتند، هم به معنای واقعی و هم مجازی. اوج مصرف انرژی بسیار بالا بود (البته نه بیشتر از R9 390X) و طراحی AMD با دما مشکل داشت. بنابراین Fury X با یک سیستم خنک کننده یکپارچه فروخته شد که البته بسیار مؤثر بود.

نسخه غیر X از این سری به دلیل داشتن کلاکهای پایینتر و 8 واحد محاسباتی غیرفعال، تقریباً به اندازه کافی خنک کار میکرد که نیازی به خنک کننده جدا نباشد، و همه انواع کارتهای تولید شده به دست توسعه دهنگان ثالث از ترکیب هیت سینک و فن سنتی استفاده میکردند. همانطور که Radeon R9 Nano، نسخه ضعیفتر AMD Fury X که یک ماه بعد به بازار آمد نیز شرایطی مشابه داشت.

کارتهای گرافیک خط Fiji با اختلاف زیادی بهترین عملکرد AMD را داشتند و با وجود برچسب قیمت، گرما و حافظه نسبتاً کم، فروش بسیار خوبی داشتند. البته که شرکت سرخ میدانست با رقابت سختی از سوی انویدیا روبرو خواهد شد، حتی اگر شرکت سبز به طور کلی نیمه اول سال نسبتاً عادی را با توجه به محصولات جدید و هیجان انگیز AMD داشتند.

چیز دیگری که AMD در اوایل سال 2015 ارائه کرد فناوری FreeSync بود، جایگزینی برای فناوری G-Sync اختصاصی انویدیا. برای هر دو سیستم، نرخ بهروزرسانی متغیر بودند که به مانیتورها اجازه میدادند تا با بهروزرسانیهای فریم همگام شوند و مشکل پارگی صفحه را کاهش دهند، بدون اینکه نرخ تغییرات در محل قفل شود.

پردازندههای گرافیکی Radeon برای مدتی پس از شروع بازی توانایی انجام این کار را داشتند، در حالی که تراشههای GeForce در آن زمان نیاز به تعبیه یک دستگاه خارجی در مانیتور داشتند.

برای انویدیا، اکثر نسخههای آنها مدلهای مقرون به صرفه و میانرده بودند که قابلتوجهترین آنها GeForce GTX 960 بود که در ابتدای سال ظاهر شد. این کارت خوش قیمت تنها با 199 دلار و با استفاده از 120 وات، نشان دهنده بهتر پیشرفت انویدیا با معماری Maxwell بود.

از نظر عملکرد، همتراز با کارتهای مانند Radeon R9 280 و 280X بود و البته از نظر قیمت کمی ارزانتر بود. این کاملاً به تفاوت بین تراشههای مورد استفاده در محصولات رقیب مربوط میشود، GTX 960 دارای یک GPU 228 میلیمتر مربعی بود که شامل 2.94 میلیارد ترانزیستور بود، در حالی که مدلهای قدیمیتر AMD از تراشههای 432 میلیمتر مربع با 4.31 میلیارد ترانزیستور استفاده میکردند.

با وجود اینکه هر دو بر روی فرآیند 28 نانومتری TSMC ساخته شدهاند، معماری جدیدتر نشان میدهد که از زمانی که GCN 1.0 برای اولین بار ظاهر شد، چقدر پیشرفت حاصل شده است.

در انتهای دیگر مقیاس پردازنده گرافیکی، انویدیا تنها دو مدل جدید ارائه کرد و هر دو از یک تراشه GM200 استفاده کردند. GeForce GTX Titan X در ماه مارس و GeForce GTX 980 Ti در ماه ژوئن عرضه شد. با برچسب قیمت 999 دلار، مدل اول در یک بازار بسیار خاص مورد هدف قرار گرفت، اما Ti 980 با قیمت 649 دلار به بازار عرضه شد که البته هنوز بسیار گران بود، اما برای مخاطبان گستردهتر بسیار خوشایندتر جلوه میکرد.

کارت گرافیک Radeon R9 Fury X هنوز ظاهر نشده بود و کارتهای گرافیک برتر Nvidia در برابر کارتهایی مانند R9 295X2 و 290X قرار میگرفتند. بسته به بازی، آنها عملکرد بهتری را ارائه میکردند، اگرچه مدلهای AMD به مراتب مقرون به صرفهتر بودند.

سال 2015 همچنین شاهد انتشار و اطلاعیههای نرمافزاری بودیم که مسیری را که پردازندههای گرافیکی و فروشندگان آنها برای معماریهای آینده خود دنبال میکردند، شکل میداد. در ماه مارس، در کنفرانس سالانه توسعه دهندگان بازی، گروه Khronos به طور عمومی پروژهای را که روی آن کار میکردند معرفی کرد: پس از این کنفرانس Vulkan به یک موضوع داغ تبدیل شد.

این API گرافیکی جدید مزایای قابل توجهی را نسبت به OpenGL و Direct3D ارائه میکرد که عمدتاً به شکل انتقال بسیاری از مدیریت حافظه، رشتهها و خود GPU به توسعهدهندگان و به دور از درایورهای GPU بود. این امر به کاهش شدید فشار موجود بر CPU که سیستمهای موجود در آن زمان با آن دست و پنجه نرم میکردند، کمک میکند.

چهار ماه بعد، مایکروسافت ویندوز 10 و همراه با آن، DirectX 12 را معرفی و عرضه کرد.

بخش گرافیکی این API به نام Direct3D ویژگیهای مشابه Vulkan را ارائه میکرد، اگرچه فقط به سیستم عامل جدید محدود میشد در نتیجه کاربرانی که نسخههای قدیمیتر ویندوز را داشتند مجبور شدند با DirectX 11 باقی بمانند.

البته نه اینکه این فناوری بهترین شروع تبلیغاتی را داشته باشد. اولین بازی DirectX 12، طبیعتاً یک بازی مایکروسافت بود که احتمالا بتوانید نام آن را حدس بزنید: Gears of War: Ultimate Edition. این عنوان یک آشفتگی فنی و گرافیکی فاجعه بار بود، با اشکالات متعدد و عملکرد وحشتناک. بازیهای دیگری که از API جدید استفاده میکردند قرار بود در سال بعد ظاهر شوند، اما زمان بیشتری طول میکشید تا نرمافزار به پتانسیل کامل خود برسد.

یکی از ویژگیهای آن، محاسبه ناهمزمان، مورد توجه توسعه دهندگان بود. شیدرهای محاسباتی برای مدتی بخشی از DirectX بودند، اولین بار در DX11 در سال 2008 (و از طریق برنامه های افزودنی در OpenGL و نرم افزار CUDA انویدیا) ظاهر شدند. این سایهزنها که بهطور خاص توسط API DirectCompute مدیریت میشوند، روی خط لوله جداگانهای به خط گرافیکی (مانند راس، هندسه، سایهزنهای پیکسل) اجرا میشوند و توانایی محاسباتی همهمنظوره بیشتری را برای یک GPU به کار میگیرند.

جابهجایی بین خطوط لوله معمولاً منجر به کاهش عملکرد میشود، بنابراین توانایی اجرای هر دو به طور همزمان با محاسبه ناهمزمان به طور بالقوه قدرتمند و منسب جلوه میکرد. با این حال، علیرغم اینکه هر دو AMD و Nvidia ادعا میکنند آخرین معماریهایشان با DirectX 12 مطابقت دارد، تنها پردازنده گرافیکی AMD بهترین استفاده را از این ویژگی کرد، تراشههای Maxwell انویدیا برای کارکرد به این شیوه بهخوبی طراحی نشده بودند.

قبل از پایان سال، گوگل نرم افزار TensorFlow خود را به منبع باز تغییر داد و به عموم دسترسی کامل به کتابخانه هوش مصنوعی و ابزارهای یادگیری ماشین داد. اگرچه اولین در نوع خود نبود، تلاشهای گوگل در آن سال با شرکتهای اینتل (با DAAL)، مایکروسافت (CNTK) و آپاچی (MXNet) مطابقت داشت.

در جایی که نرمافزار اینتل عمدتاً برای پردازندههای مرکزی بود، گوگل و آپاچی برای استفاده در انواع سختافزارها باز بودند، و هر دو AMD و Nvidia به سرعت از آنها با جعبهابزار و درایورهای خود پشتیبانی کردند. گوگل به توسعه «GPU» خود، به نام واحد پردازش تنسور، ادامه داد تا شبکههای عصبی خاص را تسریع بخشد.

کارتهای گرافیک قبلاً برای چنین نقشهایی مورد استفاده قرار میگرفتند، اما تقاضای فزاینده برای توانایی محاسباتی موازی گسترده بر نحوه توسعه پردازندههای گرافیکی غالب میشد. اولین تلاش جدی انویدیا به دنیای یادگیری ماشینی (Machine Learning) به شکل Jetson TX1 و Nvidia DRIVE بود.

هر دو سیستم از Tegra X1 SoC استفاده میکردند. این تراشه کوچک حاوی هستههای CPU و GPU با استفاده از معماری Arm Cortex-A57 برای اولی و طراحی خود انویدیا Maxell برای دومی بود. در حالی که انویدیا هیچ مدرکی نبود، اما این قضیه نقطهای را در تاریخچه انویدیا مورد بررسی قرار داد که نشان میداد آنها بر روی انجام کارهایی بیش از بازی کردن متمرکز هستند.

سالی طلایی برای پردازندههای گرافیکی

هر علاقهمند به رایانه شخصی، سختافزار مورد علاقهای برای خود خواهد داشت، حال این علاقه میتواند به دلایل احساسی باشد یا مالی، و بسیاری از آنها در سال 2016 تولید شدهاند. سال 2016 بهشت عرضه کارت گرافیکها برای مصرف کننده بودند. برخی از آنها حتی اکنون نیز در در بین محبوبترین کارت گرافیکها قرار دارند.

شرکت AMD همچنان بر روی رسیدگی به تراز بانکی خود (متعادل کردن سود و زیان شرکت که از سالهای قبل حاصل شده بود) متمرکز بود و بیشترین بخش از بودجه تحقیق و توسعه خود را به CPU ها اختصاص داد. بنابراین بخش گرافیک، Radeon Technologies Group، بر بهبود حاشیه سود از طریق بهبود بازده تولید و تنها پیشرفتهای نسبتاً کوچک معماری متمرکز شد.

تراشههای GCN 4.0 با عرضه سری کارتهای Radeon RX 400 در ماه ژوئن ظاهر شد، مدلهای میانرده و مقرونبهصرفه همچنان دارای تراشههای GCN 1.0/2.0 بودند، اما RX 480 از طراحی تراشه جدید بهره میبرد. مصرف انرژی این پردازنده گرافیکی به طور قابل توجهی از دستگاههایی مانند Fiji با تنها 36 واحد محاسباتی (CUs) کاهش یافته است.

ساختار گرافیکی با اسم رمز Polaris 10 (یا Ellesmere) نسبت به GCN 3.0 بدون تغییر باقی ماند اما دارای صفحه نمایش و موتورهای ویدئویی بسیار بهبود یافته بود. اما ویژگی کلیدی Polaris اندازه آن بود: تنها با 232 میلی متر مربع، 60 درصد کوچکتر از Fiji بود. بخشی از دلیل این امر ناشی از استفاده از CU های کمتر است.

دلیل اصلی تغییر استفاده از TSMC به GlobalFoundries برای وظایف تولید GPU بود. GloFo، همانطور که اغلب به این اسم نامیده میشود، در سال 2009 تشکیل شد، زمانی که AMD بخش ساخت خود را فروخت و برای تولید Polaris، آنها مجوز فرآیند 14LPP سامسونگ را صادر کردند.

این سیستم از FinFET ها به جای ترانزیستورهای مسطح استفاده میکرد، همانطور که TSMC در ساخت 28 نانومتری خود استفاده میکرد که نسلهای قدیمیتر از Polaris را ساخت. به روز رسانی امکان دستیابی به سرعت کلاک بالاتر را فراهم میکرد، در حالی که مصرف انرژی را کاهش میداد و قابلیت پردازش تراکم اشکال بسیار بالاتری را ارائه میداد.

کارت گرافیک Radeon RX 480 به گونهای طراحی نشده بود که بالاترین عملکرد را در بازار داشته باشد، بلکه مقرون به صرفهترین کارت بود، و به نظر میرسید که با قیمت 240 دلار بر روی کاغذ با بنچمارکهای مطرح شده از شرکت مطابقت داشته است. در واقعیت، این کارت خوش ساخت و خوش قیمت بهتر از مدلهای قدیمیتر Radeon R9 390 و GeForce GTX 970 نبود، و علیرغم اینکه هر دو مدل با قیمتی تقریباً 100 دلاری عرضه میشدند، مصرف کنندگان تا این زمان میتوانستند با همان قیمت کارتهای بیان شده را خریداری کنند.

با این حال، برای AMD، اندازه کوچک به این معنی است که بازده تولید بسیار بهتر از بازدهی است که در معماری Fiji به دست آمد و از سمت دیگر بازدهی بهتر برابر با حاشیه سود بهتر است.

انویدیا با استفاده از فرانید ساخت جدید FinFET 16FF برای ساخت معماری جدید خود، Pascal، با TSMC باقی ماند. این معماری اولین بار در ماه می 2016 در قالب GeForce GTX 1080 به بازار آمد تا سلطه شرکت سبز را بر بازار کارت گرافیک بیش از پیش کند.

طراحی انویدیا همچنین از مزایای فناوری جدید ترانزیستور بهره برد و اگرچه به کوچکی Polaris 10 نبود، تراشه GP104 که 1080 را تامین میکرد، 21 درصد کوچکتر از GPU در GTX 980 بود.

در داخل GTX 1080 38 درصد ترانزیستورهای بیشتر (در مجموع 7.2 میلیارد)، کلاک 42 درصد بیشتر و تنها 10 درصد بیشتر از نسل قبلی خود مصرف انرژی داشت. همچنین نسخه سریعتری از RAM به نام GDDR5X داشت که بیش از 40 درصد پهنای باند حافظه بیشتری نسبت به GDDR5 980 میدهد.

کارت MSRP برای مدل موسوم به "" Founders Edition با قیمت 699 دلار قیمت گران قیمت حساب میشد، اگرچه برخی از کارتهای شرکتها ثالث حتی از 100 دلار کمتر شروع میشد. اما بهطور متوسط حدود 60 درصد سریعتر بودن از GTX 980 و حدود 30 درصد سریعتر بودن از بهترین AMD (Radeon R9 Fury X)، در عملکرد باعث شد که فروش بسیار خوبی داشته باشد.

طی شش ماه آینده، انویدیا سه پردازنده گرافیکی جدید را با استفاده از معماری پاسکال عرضه کرد: GP102، 104، و 106. دو مورد آخر قدرتهایی مانند GTX 1070، 1060 و 1050 را تامین میکردند. تمام این کارت گرافیکها در بین مصرف کنندگان و منتقدان محبوب و پر فروش بودند.

کارت گرافیک Titan X با قیمت سفارشی 1199 دلار روانه بازار شد که 70+٪ گرانتر از GTX 1080 بود. این رقم بسیار زیاد با مشخصات پردازنده گرافیکی مطابقت داشت: 3584 واحد سایه زن که تا 11 TFLOPS توان FP32، 12 گیگابایت رم GDDR5X دارند. و 384 گیگابایت بر ثانیه پهنای باند حافظه. این رقمها همه خبر از قدرت ماورا تصور این کارت میدادند.

اما با وجود این همه قدرت بر روی کاغذ، در عمل حتی 70 درصد نیز سریعتر از GTX 1080 نبود. بسیاری از آزمایشات نشان دادند که به طور متوسط حدود 25٪ بهتر است. البته که به نظر نمیرسید که این مورد در بین هواداران و گیمرها مهم باشد، زیرا Titan X به اندازه برادران کوچکترش فروش داشت.

بازار کارتهای گرافیکی سال 2016 تقریباً برای هر بودجه، از 100 دلار تا 1000 دلار، چیزی را ارائه میکرد. عملکرد و ثبات GPU به طور قابل توجهی بهتر از قبل بود و توسعه دهندگان بازی شروع به استفاده کامل از قابلیتهای آنها کردند.

انویدیا درآمد خوبی داشت و در حالی که سهم بازار آن به دلیل محبوبیت خط تولید RX 400 AMD کاهش یافت، به دلیل کاهش طولانی مدت فروش جهانی رایانههای شخصی رومیزی، فروش کلی کارتهای گرافیک مجزا به طور پیوسته کاهش یافت.

هستههای پردازشی بیشتر، گرمای بیشتر... و دلارهای بیشتر!

در حال حاضر، فروشندگان GPU در یک الگوی قابل پیشبینی معقول قرار گرفته بودند: یک معماری جدید هر دو سال یا بیشتر منتشر میشد، با بهروزرسانیهای خط تولید در بین آنها، یا گاهی اوقات هر دو به طور همزمان.

برای AMD در سال 2017، این مورد دومی بود. Radeon RX 480 یک تغییر و افزایش جزئی در کلاک ایجاد کرد و به RX 580 تغییر نام داد، با قیمت 70 دلار کمتر از GeForce GTX 1060، در کل کمی سریعتر از آن عمل کرد، البته با مصرف انرژی بالاتر.

کارت گرافیک Radeon RX 560 میان رده یک پیشرفت قابل توجه نسبت به RX 460 بود که بر اساس آن ساخته شده بود: دو واحد محاسباتی اضافی، رم بیشتر و کلاکهای بالاتر با قیمتی تقریباً 99 دلاری. کارت گرافیک GeForce GTX 1050 انویدیا که یک سال از عمر آن میگذشت، کمی کارآمدتر و عملکرد بهتری داشت، اگرچه قیمت نیز آن کمی بالاتر بود.

شایان ذکر است که GP107 که قدرت 1050 را تامین میکرد توسط سامسونگ ساخته شده است و با استفاده از فرایند ساخت 14 نانومتری خود (همان چیزی است که توسط GloFo برای ساخت GPU Polaris 21 در RX 560 استفاده میشد) هر دو دارای رتبه TDP (قدرت طراحی حرارتی) 75 وات بودند. با این وجود پردازنده انویدیا ترانزیستورهای بیشتر و سرعت کلاک بالاتری داشت.

کنترل نسبتا ضعیفتر AMD بر قدرت کارت گرافیکها خود بار دیگر با کارتهای Radeon RX Vega که در اواسط آگوست عرضه شد برجسته شد. معماری Graphics Core Next یک بار دیگر به نسخه 5.0 به روز شد و پردازندههای گرافیکی Fiji اساساً دوباره متولد شدند. مدل رده بالای RX Vega 64 دارای تراشه 12.5 میلیارد ترانزیستوری بود که 40 درصد بیشتر از Fiji بود، اما به دلیل فرایند ساخت بهتر و ابعاد 495 میلی متر مربع به 596 میلی متر مربع در جایگاه بعدی بود.

تراشه کوچکتر همچنین به لطف استفاده از فناوری جدید HBM2 از رم بیشتری پشتیبانی میکرد و عملکرد کلی تقریباً مشابه GeForce GTX 1080 بود با قیمتی 100 دلار کمتر از 1080.

انویدیا در این بین محصول جدیدی عرضه نکرد و خود را به زحمت اضافی نینداخت. علت نیز ساده بود. طیف وسیعی از کارتهای گرافیک با معماری Pascal آنها فروش خوبی داشت و در ماه مارس، با GeForce GTX 1080 Ti، قدرت خود را برای عاشقان گرافیک و علاقهمندان تقویت کردند. این کارت گرافیک جدید از همان تراشهای استفاده میکرد که در Titan X یافت میشد، البته با تعداد واحدهای سایه زن فعال کمتر.

اما با ساعتهای بالاتر، عملاً مانند مدل halo عمل میکرد، اما با قیمت 500 دلار کمتر فروخته میشد که گران به نظر میرسید. این شروع عرضه همچنین شاهد کاهش 100 دلاری MSRP برای GTX 1080 بود و فروش هر دو مدل رکوردهای جدیدی را برای شرکت "سانتا کلارا" (Santa Clara) ثبت کرد.

انویدیا معماری جدیدی را در سال 2017 معرفی کرد، اما نه برای مصرف کنندگان عمومی. هدف Volta بازار محاسبات حرفهای بود، اما طراحی و مجموعه ویژگیهای آن به شدت بر مسیر محصولات آینده GeForce تأثیر گذاشت.

این اولین تراشه انویدیا بود که دارای معماری انحصاری برای یک بازار خاص بود. تمام محصولات قبلی متمرکز بر محاسبات، مانند تسلا K80، از ساختارهای موجود در تراشههای دسکتاپ و موبایل مصرفی گرفته شده بودند. Volta کاملاً با Pascal متفاوت نبود، اما با 815 میلیمتر مربع اندازه، با 21.1 میلیارد ترانزیستور و 5120 واحد سایهزن، بزرگترین پردازندهای بود که تا به حال ساخته شده بود.

در انتهای دیگر این مقایسه، GPU های ادغام شده در CPU یا سیستم روی تراشه (SoC) نیز پیشرفت قابل توجهی داشتهاند. اگرچه اینتل با CPUهای Coffee Lake مرزهای فناوری جدیدی را ایجاد نکرده نبود، معماری گرافیکی آنها به Gen 9.5 و بسته به مدل CPU، تا 48 EU رسیده بود (هر یک اکنون 7 رشته و حداکثر 4 قابل صدور در هر ساعت دستورالعمل دارد)

به طور طبیعی، عملکرد بازی همچنان به دلیل مقیاس کلی GPU با مشکل مواجه بود و نسبت به CPU های جدید مبتنی بر Zen AMD با پردازندههای گرافیکی Vega یکپارچه نسبتاً ضعیف عمل میکرد. اما در هر حال این موضوع نشان داد که اینتل همچنان مصمم به بهبود معماری است.

این امر به ویژه زمانی مشخص شد که آنها اعلام کردند که رئیس AMD گروه Radeon، Raja Koduri، با هدف خاص توسعه محصولات گرافیکی گسسته جدید به اینتل پیوسته است.

آخرین باری که اینتل یک گرافیک مجزا را برای بازار رایانههای شخصی دسکتاپ ارائه کرده بود، نزدیک به دو دهه پیش بود، و در حالی که پردازندههای گرافیکی یکپارچه مهم بود، مقیاس کردن چنین طرحهایی در محصولات رقابتی برای مبارزه با محصولات AMD و انویدیا کاملاً متفاوت بود.

دنیای گوشیهای هوشمند نیز با پردازندههای گرافیکی خود شاهد پیشرفت مداومی بود. اپل با موفقیت از طراحی خود استفاده کرد، و اگرچه عناصری از سیستم از فناوری دارای مجوز PowerVR استفاده میکردند، اما آنها اعلام کردند که راه خود را از هم جدا میکنند. اقدامی که صدمات جبرانناپذیری به شرکت fabless وارد کرد.

برای طرفداران اندروید، Arm پردازندههایی مانند Mali-T860 را ارائه کرد و Qualcomm دارای یک GPU کاملاً قابل احترام در سری Snapdragon 600 SoC های موبایل خود بود. حتی تراشه دو ساله Tegra X1 انویدیا توانست مکان مناسب خود را در دل کنسول Nintendo Switch پیدا کند.

این باید «سال طلایی» دیگری برای پردازندههای گرافیکی باشد. مدلهای متعددی برای هر بودجه و بخش وجود داشت، و AMD و Nvidia بهجز در بالاترین عملکرد گرافیکی که شرکت سبز بهتر بود، در بقیه موارد بهطور منطقی با هم عملکرد یکسانی را ارائه میدادند.

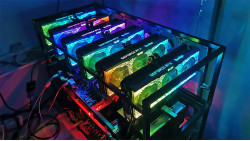

با این حال، چیزی که چندین سال در پسزمینه در حال شکلگیری بود، ناگهان منفجر شد و گیمرها و علاقهمندان به رایانههای شخصی بار عمده پس لرزه آن را متحمل شدند. استفاده از پردازندههای گرافیکی برای استخراج ارزهای دیجیتال به دلیل افزایش شدید قیمت بیتکوین به طرز چشمگیری افزایش یافت.

عرضه پردازندههای گرافیکی جدید به پایان رسید و قیمت کارتهای دست دوم به طور قابل توجهی افزایش یافت. خرید کارت گرافیک تبدیل به یکی از طاقت فرساترین کارهای صنعت گیم شد زیرا مشخص شد که پردازندههای گرافیکی در انجام بسیاری از ریاضیات ساده به طور انبوه بسیار خوب هستند. پردازندههای گرافیکی AMD بهویژه در محاسبات خوب بودند، اگرچه پردازندههای انویدیا در مصرف انرژی کارآمدتر بودند.

صرف نظر از تفاوت، هر دو مدل میان رده و رده بالا شاهد افزایش مداوم قیمت (و همچنین کمبود مداوم در دسترس بودن به دلیل کمبود قطعات) بودند که در سال بعد این موضوع به اوج خودش رسید و بحران سراسری دنیای سخت افزار را در بر گرفت. و اگر مصرف کنندگان امیدوار بودند که محصولات سال 2018 با قیمت مناسبتری به بازار وارد شوند، مجددا شوکه شدند.

تکنولوژی جدید، نامهای بازاریابی جدید و صد البته قیمتهای جدید!

شرکت AMD از راهاندازی موفقیتآمیز معماری کاملاً بازطراحیشده Zen CPU خود لذت برد، پس از آن رویکرد محتاطانهای را برای صرف منابع محدود (اعم از مالی و فیزیکی) برای توسعه پردازندههای گرافیکی خود در نظر گرفت. به جای تازه کردن ویژگیهای داخلی یک تراشه یا معرفی بهروزرسانی برای Vega، آنها به سنتهای آشنا پایبند بودند: rebadging.

بنابراین، سری Radeon RX 500 مانند سال قبل باقی ماند، البته با علامت X روی نام مدل آن (برای مثال، RX 580 تبدیل به RX 580X شد و غیره.) برخی از مدلهای میانرده و مقرونبهصرفه، میزان رم خود را افزایش دادند، اما تغییرات دیگر جزئی بودند و در عمل تاثیر چندانی در عملکرد نداشتند.

تنها محصول جدیدی که AMD به بازار عرضه کرد Radeon RX 590 بود. این مصحول از تراشه GCN 4.0 Polaris مشابه RX 580 استفاده کرد و مشخصات آن نیز تقریباً یکسان بود. با این حال، این تراشه توسط GlobalFoundries و سامسونگ با استفاده از فرایند ساخت بهبود یافته (GloFo - 12LP، Samsung - 11 LPP) ساخته شده است.

نتیجه نهایی کاهش 5 درصدی در TDP، 17 درصد کلاک پایه بالاتر و 15 درصد کلاک تقویتی بالاتر بود و برای بهتر مقایسه کردن آن با رقیب، 50 دلار هم قیمت بالاتر در MSRP داشت. چنین تغییرات جزئی به هیچ وجه باعث برجسته شدن RX 590 نشد و 580 (اکنون در قالب 580X) در فروشگاهها بسیار بهتر عمل کرد.

انویدیا سال 2018 را به شیوهای مشابه آغاز کرد و نسخههای اصلاح شده سری GTX 10 خود را وارد بازار کرد، مانند GeForce GT 1030 که مجهز به DDR4 بود. هیچ کدام از موارد اصلاح شده چیز جدیدی را به همراه خود نیاوردند، اما در چند ماه اول سال این مورد اصلا اهمیتی نداشت، زیرا قیمت GPU بسیار بالا بود و در هر حال اگر فناوری و کارت گرافیک جدیدی هم معرفی میشد کسی توانایی خرید نداشت.

در تابستان، اوضاع بهبود یافته بود و علاقه مندان به رایانه شخصی مشتاقانه منتظر معماری جدید انویدیا بودند. شکاف بین طراحیهای جدید GeForce در طول دهه به طور پیوسته در حال افزایش بود (یک فاصله 15 ماه Maxwell را از Kepler جدا کرد و 28 ماه بین Pascal و Maxwell وجود داشت.

اولین پردازندههای گرافیکی Turing در ماه آگوست و سپتامبر در قفسهها ظاهر شدند. اولین مدل Quadro برای بازار ایستگاههای کاری حرفهای بود. سری GeForce نه تنها پردازندههای گرافیکی و کارتهای جدید را برای خرید به ارمغان آورد، بلکه فنآوری و شرایط بازاریابی جدید را نیز به ارمغان آورد.

انویدیا از سال 2005 از برچسب "GTX" به عنوان پیشوند یا پسوند استفاده میکرد، اما در آن سال آنها نام حافظههای گرافیکی خود را به RTX تغییر دادند، و بخش RT عملاً برای ردیابی پرتو در کنار حرف ایکس ایستاده است. همانند شبیه فیلم و بسیار نزدیکتر به آن، توانایی مدلسازی دقیقتر نور در زمان واقعی در یک کارت گرافیک رومیزی استاندارد در دسترس بود.

پیش از این، مایکروسافت یک API جدید به نام DirectX Raytracing (DXR) در رویداد GDC آن سال معرفی کرده بود. آنها نحوه عملکرد سیستم را توضیح دادند و تعدادی ویدیو از EA، Epic و Futuremark را به نمایش گذاشتند. در حالی که Nvidia و نام RTX نیز درگیر بودند، این موضوع از طریق پردازندههای گرافیکی Volta در حال جریان بود، نه Turing.

حال سوال اینجا بود که این معماری جدید چگونه ردیابی اشعه را با GeForce RTX 2080 و Ti 2080 که هر دو از یک تراشه TU102 استفاده میکنند، مدیریت میکند. با 18.6 میلیارد ترانزیستور و 754 میلیمتر مربع اندازه، GP102 مبتنی بر Pascal را در مقایسه با آن کوچک جلوه داده است. با وجود داشتن بیش از 4600 هسته سایه زن، تنها 20 درصد عملکرد بیشتر از نسل قبلی خود داشت، پس چرا اینقدر بزرگتر بود؟

تغییرات زیادی در زیر بدنه باعث افزایش ابعاد شده بود. اندازه کشهای L1 و L2 دو برابر شد، پهنای باند داخلی بسیار بهبود یافت، و افزودن هستههای تانسور و ردیابی پرتو به هر SM (چند پردازنده جریانی) در GPU، همگی نقش خود را ایفا کردند.

هستههای تانسور (اساساً مجموعهای از ALUهای FP16، بنابراین کد سایهزن FP16 را نیز مدیریت میکردند) در Volta ظاهر شده بودند، اما کمی هم برای Turing بهروزرسانی شده بودند. هستههای RT کاملاً جدید بودند و هر یک شامل دو واحد تخصصی بود: یکی برای مدیریت الگوریتمهای پیمایش BVH و دیگری برای آزمایش تقاطعهای پرتو اولیه.

جدای از تکنولوژی، چنین مدارهایی کاملاً ضروری نیستند، زیرا ردیابی پرتو را میتوان بر روی پردازندههای مرکزی انجام داد (و این مورد بعدها انجام شد). اما برای انجام آن در زمان واقعی، در بازیهای روزمره که هر کسی میتوانست آن را بخرد، چنین سختافزاری کاملاً مورد نیاز بود.

با این حال، با ارائه هیچ عنوانی برای آزمایش، ارائه پشتیبانی از DXR یا معادل آن از طریق افزونههای OpenGL/Vulkan، وقتی تراشههای تورینگ جدید ظاهر شدند، گیمرها به عملکرد خام آن در بازیهای «عادی» روی آوردند. نتایج، حداقل برای نسخه Ti، بهطور مناسبی تحت تأثیر قرار گرفتند و تسلط انویدیا را بر تاج بالایی دنیای کارت گرافیک تثبیت کردند.

با این حال، آنچه بسیار کمتر تاثیرگذار بود، عرضه سری جدید MSRPs بود. قابل ذکر است که برای GeForce RTX 2080 Ti، انویدیا برچسب را 999 دلار و 699 دلار برای 2080 (و 100 دلار اضافی برای Founders Editions) تعیین کرده بود.

در مورد اولی، 300 دلار بیشتر از GTX 1080 Ti بود، اگرچه RTX 2080 یک افزایش 100 دلاری دلپذیرتر از 1080 بود. اما با بازگشت مقادیر GPU به حالت عادی پس از شکست استخراج کریپتو، 43٪ افزایش قیمت Ti برای بسیاری غیرقابل توجیه بود.

با توجه به اینکه خط Turing هنوز توسط TSMC ساخته میشد، البته در یک نسخه سفارشیشده از فرآیند ساخت 16FF آن (با برچسب 12FFN)، تراشههای عظیم هرگز بازدهی مشابهی را ایجاد نمیکردند که قالبهای Pascal GP102 38 درصد کوچکتر میتوانند به دست آورند. AMD مشکل مشابهی را با شرکت هایی مانند Fiji و Vega تجربه کرده بود، اگرچه آنها تمایل بیشتری به جذب هزینههای تولید بالاتر دارند.

یکی دیگر از عناصر کارتهای GeForce RTX جدید توسط انویدیا مورد تبلیغ قرار گرفت: DLSS یا Deep Learning Super Sampling بود. ایده کلی پشت DLSS این است که همه چیز را با وضوح تصویر پایینتر ارائه کنیم، سپس از الگوریتمی استفاده کنیم که توسط یادگیری ماشین تعیین میشود تا فریم نهایی را به وضوح تصویر نمایشگر ارتقا دهیم.

هستههای تانسور بهعنوان یک عنصر کلیدی در پشت این ویژگی تبلیغ میشدند، اما اولین نسخه DLSS از آنها در کارتهای گرافیک مصرفکننده استفاده نمیکرد. در عوض، همه این کارها توسط شبکههای کامپیوتری خود انویدیا انجام میشد که برای تجزیه و تحلیل هر بازی، فریم به فریم، استفاده میشد تا مشخص شود که روال ارتقاء مقیاس چگونه خواهد بود.

برداشت های اولیه مثبت بودند، زیرا وضوح تصویر پایینتر عملکرد را بهبود میبخشد، در حالی که ارتقاء به اندازه کافی برای حفظ کیفیت تصویر مناسب بود. اما مانند ردیابی پرتو، هیچ بازی کاملی با استفاده از فناوری برای ایجاد Turing وجود نداشت.

یک فرایند یکسان و یکنواخت، یک شروع جدید و یک تغییر باطن

برای علاقه مندان به صنعت سختافزار، پایان سال 2018 و ماههای اولیه 2019 فرصت بهتری برای بررسی مجموعه ویژگیهای RTX انویدیا فراهم کرد. در آن زمان، عناوین مختلفی وجود داشت که از DXR و DLSS پشتیبانی می کردند.

امثال Battlefield V، Shadow of the Tomb Raider و Metro Exodus همگی از این سیستمها در درجات مختلف استفاده کردند، اما دو چیز به سرعت آشکار شد: استفاده از ردیابی پرتو پتانسیل بهبود قابل توجهی واقع گرایی نور جهانی، سایهها، و بازتابها را به همراه دارد و دوم، هزینه عملکرد فوقالعاده بالا بود و تنها استفاده از DLSS به حفظ ظاهری از قابلیت پخش کمک کرد. و این در 1080p بود. پیدا کردن وضوح بالاتر از این به سادگی یک گزینه نبود.

در حالی که نرخ فریم 30 فریم بر ثانیه یا کمتر معمولاً برای کنسولها معمول بود، هنگام اجرای بازیهایی با گرافیک فوقالعاده، آن چیزی بود که علاقهمندان به رایانه شخصی هنگام پرداخت 1000 دلار برای یک کارت گرافیک انتظار داشتند.

تقریباً در این زمان، AMD و Nvidia کارتهای گرافیک جدیدی منتشر کردند. شرکت سرخ محبوب Radeon VII را به ما داد، در حالی که شرکت سبز رنگ GeForce RTX 2060 را معرفی و عرضه کرد و بازگشت نام GTX را با 1660 Ti ارائه کرد.

کارت گرافیک Radeon VII آواز قوي GCN خواهد بود: آخرين نسخه از آن معماري قديمي، يا اينطور به نظر ميرسد قبل از اينكه AMD به چيز جديدي روي آورد. تراشهای که این کارت را تامین میکند Vega 20 بود، نسخهای از آن که در Radeon Vega 64 یافت میشود، البته با کمی تغییرات، و بر روی گره جدید 7N TSMC ساخته شده است.

روی کاغذ، این مدل همه چیز را داشت: 16 گیگابایت HBM2، دارای پهنای باند 1024 گیگابایت بر ثانیه، همراه با 60 واحد محاسباتی که تا 1800 مگاهرتز کار میکردند.

با قیمت درخواستی 700 دلار، AMD آن را در برابر GeForce RTX 2080 انویدیا قرار داد و به طور متوسط، تنها چند درصد در آزمایش عملکرد کندتر بود. اما این محصول هرگز برای گیمرها در نظر گرفته نشد، زیرا فقط یک Radeon Instinct تغییر یافته بود، یک مدل محاسباتی در سطح ایستگاه کاری و نه گیمینگ.

از طرف دیگر، GeForce GTX 1660 Ti مجهز به TU116، کاملاً با هدف اجرای عالی بازی تولید شده بود، به ویژه برای کسانی که نمیخواستند مبلغ عجیب و غریبی برای کارت گرافیک خود هزینه کنند. با 279 دلاری که برای این کارت پرداخت میکردید، باید با Tensor و RT Cores خداحافظی کرده و به محصولی که عمکلرد برابر با محصولی 100 دلار گرانتر از معماری Pascal یعنی GTX 107، سلام کنید.

کارت گرافیک GeForce RTX 2060 در ابتدای سال 2019 منتشر شد و تمام ویژگیهای یک نسخه از سری RTX را حفظ کرد. این کارت تقریبا 30٪ گرانتر از GTX 1660 Ti بود، اما به طور متوسط فقط 12٪ سریعتر بود، بنابراین منتقدین و علاقه مندان سخت افزار آنطور که به 1660 Ti روی خوش نشان دادند به این کارت گرافیک توجه نکردند.

شرکت AMD معماری جدید خود را پنهان نگه داشت تا تابستان که سری Radeon RX 5000 را با تراشههای Navi 10 عرضه کرد. معماری GCN به طور کامل بازنگری شد و به RDNA تبدیل شد و بسیاری از محدودیتهایی را که طراحی قدیمیتر از آن رنج میبرد برطرف کرد.

جایی که انویدیا قصد داشت همه بازارها را با Turing، چه معمولی و چه حرفهای راضی کند، همه چیز معماری RNDA در مورد ایجاد یک تجربه راضی بخش و سریع از بازیها بود. مشخصات اولیه این سری نشان میداد که قرار است با مواردی بدتر از Radeon Vega 64 روبهرو شویم، با واحدهای محاسباتی بسیار کمتر. اما AMD معماری را برای بهبود صدور دستورالعملها و جریان دادههای داخلی بازسازی کرد و نتیجه نهایی کارت گرافیکی بود که فاصله چندانی با Radeon VII و GeForce RTX 2070 نداشت. شرکت سرخ این کارت گرافیک خوش ساخت را با قیمت 399 دلاری که هر دو مدل و تراشه را به بازار عرضه میکرد، در برابر رقیب خود قرار داد. اندازه بسیار مناسب 251 میلی متر مربعی (به دلیل فرایند ساخت و تولید 7N TSMC)، بازدهی خوبی نیز به AMD داد. پس از مدتها شرکت سرخ توانست علاوه بر بازار پردازنده، در بازار حافظههای گرافیکی نیز حرفی برای گفتن داشته باشد و به اعتبار تقریبا از دست رفته خود بیفزاید.

در حالی که برخی از مردم از اینکه GPU جدید یک معماری برتر نیست و انتقادات در مورد پایداری و درایورها در نهایت خبرساز میشد، ناامید بودند، Navi ثابت کرد که میتوان بدون نیاز به چیپها و برچسبهای قیمت زیاد، عملکرد مناسبی در بازی داشت. در واقع AMD به دور از فناوریهای عجیب و غریب و اسمهای بلند پروازانه به همان چیزی رسیده بود که طرفداران به دنبال آن بودند، بهینه سازی عملکرد در بازی.

انویدیا اما بیکار نبود و پاسخ خود به خانواده جدیدا عرضه شده Radeon RX 5000 را در قالب مدلهای «Super» آماده کرده بود. در طول سال 2019، RTX 2080، 2070، 2060، GTX 1660 و 1650 همگی با پردازندههای گرافیکی و البته با شیدر بیشتر و سرعت کلاک بالاتر بهروزرسانی شدند. عملکرد اضافی ایجاد شده در این کارت گرافیکها مورد استقبال طرفداران قرار گرفت، البته در این برخی تغییرات جزئی عملکرد بین نسخه اصلی و Super کارت گرافیک RTX 2060 هم موجب برخی نگرانیها از سیاستهای آینده انویدیا شده بود

پروژه GPU مستقل اینتل در حال شکل گیری بود و پس از مدتی دیگر نام واضحی داشت، Xe، و برخی جزئیات در مورد مدلهای بالقوه آن در حال انتشار بود. اگرچه این اولین سری از این کارت گرافیکها بود ، اما همچنان در بازار گرافیک یکپارچه خواهد بود.

پایان یک دهه -- تراشه های جدید، تهدیدات جدید، مشکلات بدتر

از ایم پس را دیگر اکثر افرادی که این مقاله را مطالعه میکنند دقیق به خاطر دارند. سال 2020 تبدیل به سالی از ثروتهای متفاوت شد. در پس زمینه یک بیماری همه گیر جهانی، AMD، اینتل و انویدیا همگی کارتهای گرافیکی جدید حاوی معماریها و طرحهای جدید منتشر کردند.

مایکروسافت و سونی همچنین کنسولهای تازهای را با مجموعهای از فنآوریها و ویژگیهای جدید به بازار آوردند، که کنسول Xbox چندین سال بهروزرسانیهای API را با انتشار DirectX Ultimate ادغام کرد.

دنیای حرفهای محاسبات و هوش مصنوعی مانند AMD Radeon Instinct MI100 و Nvidia A100، هر دو دارای پردازندههای گرافیکی عظیم (به ترتیب 750 و 856 میلیمتر مربع) با قدرت فوقالعاده (120 CU با 23 FP32 TFLOPs یا 432TFLOPsTeducing 432 TFLOPs132F10 هستند. ).

اولی معماری CDNA جدید AMD را ارائه کرد، رویه متفاوتی از GCN که دوباره به بازاری فقط کامپیوتری متولد شد، در حالی که انویدیا از طراحی جدید Ampere استفاده کرد. این به عنوان جایگزینی مستقیم برای Volta به بازار عرضه شد و افزایش عملکرد زیادی را برای بارهای کاری هوش مصنوعی ارائه کرد.

در مورد هوش مصنوعی، انویدیا نسخه بهبود یافته DLSS را در ماه مارس معرفی کرد که از فرآیند بسیار متفاوتی نسبت به اولین نسخه آن استفاده میکرد. اکنون، هستههای Tensor موجود در کارتهای گرافیکی کاربران، الگوریتم استنتاج را برای ارتقای تصویر پردازش میکنند و در کل، سیستم جدید با استقبال خوبی مواجه شد. تغییرات عملکرد در آن نیز به وضوح قابل مشاهده بود.

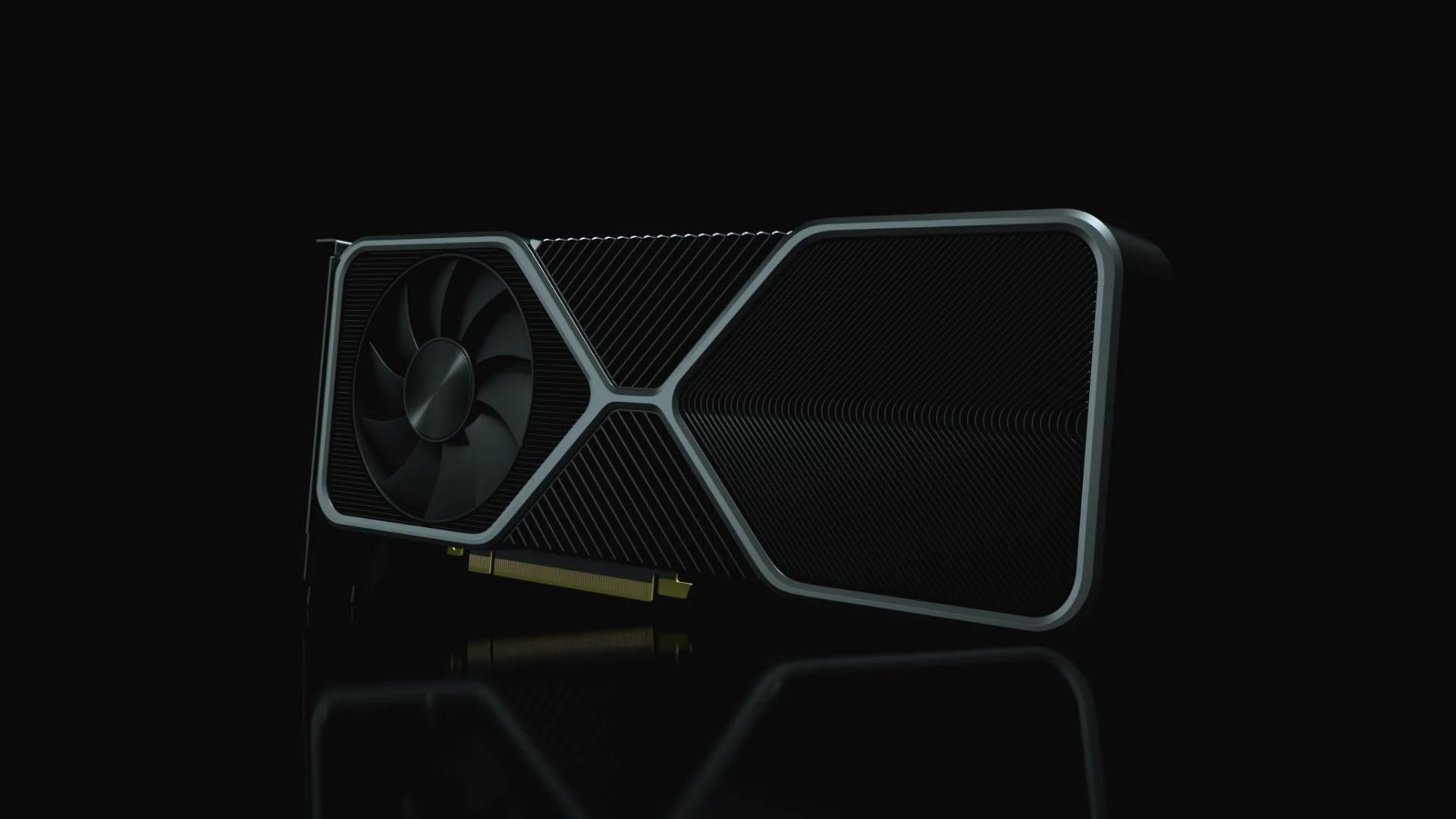

علاقه مندان به رایانههای شخصی دکستاپ باید تا اواخر سال منتظر میماندند تا دستهای جدید از پردازندههای گرافیکی داشته باشند، اما صبر آنها به خوبی با کارتهای GeForce RTX 3000 و سری کارتهای Radeon RX 6000 پاداش داده شد. مدلهای انویدیا معماری Ampere را به انبوه رساندند، اگرچه تفاوتهای قابل توجهی بین تراشه GA100 در A100 و GA102 وجود داشت که خط تولید RTX را هدایت میکرد. دومی اساساً بهروزرسانی Turing بود که شامل پیشرفتهایی در هستههای CUDA، Tensor و RT بود.

در مورد واحدهای سایه زن عمومی، ALU های عدد صحیح اکنون می توانند همان روالهای FP32 را مانند واحدهای FP انجام دهند، و انویدیا از آن برای تبلیغ سری 3000 با دو برابر تعداد هستههای قبلی خود استفاده کرد. اگرچه این مورد کاملاً درست نیست، اما به این معناست که GA102 پتانسیل ارائه توان عملیاتی و داینامیک قابل توجهی را دارد.

اما از آنجایی که بازیها کاملاً توسط شیدرهای FP32 محدود نمیشوند، عملکرد کلی RTX 3090، 3080 و 3070 کمتر از مشخصات کاغذ پیشنهادی بود، اگرچه هنوز نسبت به Turing پیشرفت قابلتوجهی داشت. بهتر از آن، قیمتهای عرضه برای این سری به طور کلی کمتر از قیمتهای سری RTX 2000 در زمان مشابه بود که شاید آن را ناشی از ترس انویدیا به باختن میدان رقابت به رقیب سرخ بدانیم.

شرکت AMD اما از RDNA استفاده کرد و جنبههای حیاتی آن مانند مصرف انرژی، فرکانسهای عملیاتی و توان داده را بهینهسازی کرد تا عواملی را که در نهایت تواناییهای کارتهای RX 5000 را محدود میکرد، کاهش دهد. RDNA 2 نشان داد که پیشرفت ثابتی که با معماری Zen انجام شده بود قرار بود اعتبار از دست رفته این شرکت را کاملا بازگرداند و به هدف بعدی شرکت تبدیل شود.

پردازنده گرافیکی Navi 21 که به نام Big Navi شناخته میشود، دو برابر تعداد واحدهای محاسباتی قبلی خود، 128 مگابایت حافظه نهان L3 و پردازندههای بافت تطبیقی که بررسیهای تقاطع مثلث پرتو در ردیابی پرتو را انجام میدهند، در خود جای داده است.

سری Radeon RX 6000 در اکثر بازیها، AMD را در یک زمین بازی برابر با Nvidia قرار میدهد، اگرچه کارتهای شرکت سرخ در زمان ردیابی پرتو بهطور قابل توجهی بدتر بودند و چیزی مانند DLSS برای افزایش عملکرد ارائه نمیدادند.

همان معماری RDNA 2، البته با CU های بسیار کمتر و بدون کش اضافی، کنسولهای جدید Xbox و PlayStation را تامین میکنند که این به AMD از نظر اقتصادی کمک بسیار شایانی میکند. همراه با پردازندههای Zen 2 روی همان قالب، سیستمهای بهروز شده باعث شد تا گیمرها از پتانسیلهایی که دستگاهها ارائه میکردند غافلگیر شوند.

حتی اینتل بالاخره یک GPU مستقل جدید را منتشر کرد، البته فقط برای سازندگان OEM و سیستم. کارت دسکتاپ Iris Xe که قبلاً با نام DG1 شناخته میشد، چیزی برای هیجانانگیز کردن مخاطبین و علاقه مندان نداشت، اما نشان داد که اینتل برای رقابت در بازار گرافیک جدی است. البته که هنوز نیاز به کسب تجربیات بسیاری در این زمینه دارد.

تمام هیجان و اشتیاق در مورد نسخههای جدید در نهایت به ناامیدی و خشم تبدیل شد، زیرا مشکلات معمول عرضه و قیمتهای اغراق آمیز به ابعاد مسخرهای افزایش یافت. برای دسکتاپ Ampere، انویدیا استفاده از سامسونگ را برای وظایف ساخت انتخاب کرد و اگرچه هرگز به طور مستقیم تایید نشد، تصور کلی که توسط بسیاری از صنایع احساس شد، این بود که بازدهی آنها به سادگی TSMC ها نیست.

با نزدیک شدن به پایان سال 2020 و شروع دهه جدید، به طور جدی تقاضا برای وسایل الکترونیکی و محاسباتی به شدت افزایش یافت، زیرا میلیونها نفر در سراسر جهان مجبور به کار از خانه شدند و حضور در فضای کاری دیگر معنایی نداشت. با جدیتر شدن اثرات کووید، تولید اجزای اساسی مانند تنظیم کنندههای ولتاژ و میکروکنترلرها به طور فزایندهای محدود شد تا یکی از تاریکترین دورانهای کارت گرافیک و به طور کلی سخت افزار رقم بخورد.

عرضه کارتهای گرافیک GeForce و Radeon بهطور استثنایی کم شد، موضوعی که در کنار استخراج کریپتو و استفاده فراگیر از رباتها برای خرید انبوه کارتها و کنسولها از وبسایتها باعث بحرانی شدن اوضاع شده بود. تقریباً هر مدل GPU موجود به طور قابل توجهی در قیمت افزایش یافت و حتی قیمتهای یک کارت دست دوم برابر یا بیشتر از قیمت آن کارت در هنگام عرضه آنها بود.

و در جایی که مصرفکننده عمومی با کمبود گزینهها دست و پنجه نرم میکرد، AMD و Nvidia هر دو از افزایش قابل توجهی در درآمد برخوردار شدند و شرکت دوم تقریباً 30 درصد رشد را در بخش بازی خود تجربه کرد. چنین ارقامی برای علاقهمندان به بازیهای رایانهای که بسیاری از آنها قادر نبودند یا تمایلی به پرداخت هزینههای گزافی که اکنون کارتهای گرافیکی طلب میکردند، آسایش کمی ایجاد میکرد.

آینده چه چیزی در انتظار شماست؟

و بنابراین، همانطور که ما قسمت آخر از تاریخچه پردازندههای گرافیکی مدرن خود را به پایان میرسانیم، کمی بیخردی است اگر که به آینده نگاه نکنیم و ببینیم آیا میتوان تعیین کرد که دهه آینده چه خواهد شد یا خیر. وضعیت کنونی مربوط به عرضه و قیمت، برای همیشه دوام نخواهد داشت، اما هیچ نشانهای از بهبود در آینده نزدیک را نشان نمیدهد. و این یعنی اخبار تیره و تاریک برای علاقه مندان صنعت سخت افزار تا مدتها قرار است شنوندگان خود را آزار دهد.

آنچه ما میدانیم این است که AMD قبلاً سال 2022 را به عنوان سال انتشار به روز رسانی برای معماریهای بازی و محاسباتی: RNDA 3 و CDNA 2 هدف قرار داده بود. که با توجه به وضعیت فعلی قرار است حالا حالاها منتظر معرفی آن باشیم.

اساساً، RDNA 2 یک نسخه اصلاحشده از پیشینیان خود است، با دستاوردهای عملکردی ناشی از ترکیبی از تغییرات طراحی برای بهبود سرعت کلاک، کارایی معماری و کاهش حرکت دادهها. تنها ویژگی جدید واحدهای شتاب دهنده بحث انعکاس اشعه است که در پردازندههای بافت ادغام شده است.

مطمئناً در سال 2022 شاهد نسخه اصلی جدید DirectX نخواهیم بود، بنابراین RDNA 3 احتمالاً بیشتر از همان بهینه سازیها و ترفندها خواهد بود. تصویر بالا بیان میکند که آن را نیز بر روی یک "گره پیشرفته" ساخته خواهد شد، اما این به ما چیز بسیار کمی میگوید. آیا آنها از گره N7+ مبتنی بر EUV TSMC یا گره دیگری مانند N6 یا N5 استفاده خواهند کرد؟

پردازنده گرافیکی Navi 21 که برای سری Radeon RX 6800 استفاده میشود، یکی از بزرگترین تراشههای AMD است که تاکنون برای بازار رایانههای شخصی رومیزی طراحی شده است، با وسعت 520 میلیمتر مربع (فقط Fiji بزرگتر بود). اما از آنجایی که این پردازنده هنوز 30 درصد کوچکتر از TU102 انویدیا است، نشان میدهد که فضایی برای یک پردازنده حتی بزرگتر برای عرضه در بازار وجود دارد.

انویدیا به طور قابل توجهی نسبت به انتشار عمومی نقشههای آینده خود خودداری میکند و اطلاعات کمی در مورد آینده آنها وجود دارد، به غیر از شایعاتی که در مورد نام آن Hopper (به نام "گریس هاپر" ( Grace Hopper)، یکی از پیشگامان علوم کامپیوتر) منتشر شده است. مانند RDNA 2، Ampere نیز بهینهسازی Turing بود و ساختار GPU را تغییر داد که در طول سال نسبتاً کمی تغییر کرده است.

و مانند طراحی Navi AMD، فرصتی برای دور بعدی پردازندههای گرافیکی انویدیا وجود دارد که واحدهای سایهزن، حافظه پنهان و غیره بیشتری داشته باشند (حتی اگر سامسونگ را برای وظایف تولید حفظ کنند، و حتی فرایند ساخت را تغییر ندهند) GA102 را میتوان قبل از اینکه به اندازه بزرگترین پردازنده Turing برسد، 20 درصد بزرگتر کرد.

اگر پردازندههای گرافیکی مانند Volta را نادیده بگیریم، که برای بازار مصرف در نظر گرفته نشده بودند، TU102 بزرگترین واحد پردازش گرافیکی بود که برای رایانههای شخصی رومیزی تولید و فروخته شد. این کارت با ابعادی در 754 میلیمتر مربع، تعداد قالبهایی را که میتوان از یک ویفر 300 میلیمتری استخراج کرد، در بهترین حالت حدود 80 یا بیشتر، محدود کرد. پس آیا میتوانیم دوباره تراشههایی به این اندازه ببینیم؟

نمونهای از بزرگترین پردازندههای گرافیکی AMD و Nvidia در طول سالها روند خطی مبهم را در رشد اندازههای قالب نشان میدهد، اما همچنین نشان میدهد که چگونه تغییر فرآیند ساخت میتواند تفاوت زیادی ایجاد کند (برای مثال، اندازههای Vega 10 و 20 را مقایسه کنید). با این حال، تنوع بسیار زیادی در دادهها وجود دارد تا بتوان از آن برای تخمین قابل اعتماد اندازه پردازنده در ده سال آینده استفاده کرد.

شاید یک رویکرد بهتر این باشد که به توان پردازشی ارائه شده توسط GPU های فوق برای چگالی واحد داده شده (یعنی میلیونها ترانزیستور در میلی متر مربع) نگاه کنیم. در حالی که اوج توان عملیاتی FP32 که بر حسب میلیاردها عملیات داینامیک در ثانیه اندازهگیری میشود، تنها معیاری نیست که باید برای قضاوت در مورد توانایی یک GPU استفاده شود، بلکه این بنچمارک به کارت گرافیکها ویژگی قابل مقایسه بودن میدهد. این به این دلیل است که عملیات سایه زن، بخش عمدهای از بار پردازش را تشکیل میدهد و برای مدتی به انجام آن ادامه خواهد داد.

وقتی به نموداری از آن شکلها (در زیر) نگاه میکنیم، تصویر متفاوتی را ترسیم میکند. نقاط پرت وجود دارد که تا حدودی بر روندها تأثیر می گذارد، اما حتی با حذف آنها، الگوی کلی به طور کلی یکسان است.

پارامتر t به ما نشان میدهد که انویدیا به طور مداوم بر افزایش قدرت پردازش خام با هر طراحی جدید تمرکز کرده است، چیزی که با توجه به نحوه استفاده از تراشههای مشابه در مدلهای عمومی و حرفهای منطقی است. این امر در مورد AMD نیز صادق بود تا زمانی که آنها RDNA را منتشر کردند، جایی که هدف این محصول صرفاً بازی است.

فناوری GCN در قالب CDNA و همچنین در پردازندههای گرافیکی یکپارچه در APU های Ryzen قرار دارد، و اگرچه تنها یک GPU از آن معماری استفاده میکند، اما در واقع پایینتر از Navi 21 در نمودار قرار میگیرد. این به این دلیل است که آن طراحی برای بارهای کاری هوش مصنوعی هدف گذاری شده است، جایی که پردازش استاندارد FP32 نسبت به بارهای کاری اعداد صحیح و Tensor اهمیت کمتری دارد.

با ارائه هر دو Nvidia و AMD، شتاب ردیابی پرتو، و همچنین پشتیبانی از فرمتهای داده و عملیات ریاضی مورد نیاز برای یادگیری ماشین در جدیدترین پردازندههای گرافیکی، رایانههای شخصی و بازیهای کنسولی این دهه به طور فزایندهای از آنها استفاده میکنند. همانطور که anti-aliasing و tessellation زمانی بیش از حد نیاز داشتند و فقط میشد تا حدودی از آنها استفاده شود، همین امر در مورد عملکرد هوگهای امروزی نیز صادق خواهد بود.

آیا این بدان معناست که پردازندههای گرافیکی 2030 به طور معمول 800 میلیمتر مربع اندازه خواهند داشت و بیش از TFLOP 1 در هر واحد چگالی تولید میکنند؟ آیا آنها به طور فزایندهای از ردیابی پرتو و یادگیری ماشینی استفاده میکنند یا بر جنبههای سنتی مانند سایه زنهای همه منظوره یا پردازش بافت تمرکز بیشتری میکنند؟ تمام موارد مطرح شده در حد احتمال است و حتی شاید اتفاقی دیگر در پیش باشد، اما یک جنبه مهم در همه اینها وجود دارد که ممکن است چنین الگوهای رشد یا تغییراتی در طراحی اساسی GPU را کاهش دهد، و همه حول محور حرکت دادهها میچرخد.

داشتن هزاران واحد سایهزن، Tensor یا هسته ردیابی پرتو خوب است، اما اگر نتوانند دادهها را با سرعت کافی استخراج کرده یا بنویسند از دست خواهند رفت. به همین دلیل است که اندازه کش و پهنای باند داخلی از زمان شروع صنعت GPGPU بسیار رشد کرده است.

مدل Nvidia G80، اولین تراشه این شرکت که از سایهزنهای یکپارچه استفاده میکند، تنها ۱۶ کیلوبایت حافظه مشترک برای هر SM (چند پردازنده جریانی)، و ۱۶ کیلوبایت کش بافت برای یک جفت SM و در مجموع ۹۶ کیلوبایت از سطح ۲ دارد. آن را با GA102 مقایسه کنید، جایی که هر SM دارای 128 کیلوبایت حافظه نهان L1 و کل GPU دارای 6144 کیلوبایت L2 است. این همان تفاوتی است که میتوان علت آن را در چندین نسل مطالعه و تحقیق و البته سرمایه گذاری دانست.

همانطور که فرآیند ساخت توسعه مییابند و اندازه و ابعاد ویژگیهای اجزا کاهش مییابد، به نظر میرسد که حتی میتوان تعداد بیشتری را نیز در آن قرار داد. با این حال، SRAM (بلاک سازنده اصلی حافظه پنهان) به مراتب بدتر از سیستمهای منطقی کاهش مییابد، و با توجه به اینکه بسیاری از پردازندههای گرافیکی مدرن در حافظه پنهان هستند، اندازه تراشهها ممکن است بدون افزایش تعداد سایهزن یا توانایی ردیابی پرتو در همان مقیاس، به اندازه بالون افزایش یابد.

یا ممکن است برعکس باشد. انویدیا (و دیگر شرکتهای مطرح) با استفاده از یک طراحی ماژولار، تحقیقات قابل توجهی در مورد مقیاسبندی عملکرد GPU انجام بدهند، این یعنی داشتن چندین دای کوچکتر در یک بسته، دقیقاً مانند کاری که AMD با چیپلتهای روی CPU های مبتنی بر Zen انجام میدهد.

در حالی که چنین تحقیقاتی عمدتاً برای بازار حرفهای بود، لازم به یادآوری است که بسیاری از ویژگیهای Volta راه خود را به Turing پیدا کردند، بنابراین ممکن است گیمرها در پایان این دهه رایانههای شخصی داشته باشند که دارای تراشههای CPU و GPU متعددی هستند که همگی در ابعادی کوچک و بهینه شده بستهبندی شدهاند. بسته های نسبتا فشرده.

اما بدون در نظر گرفتن فرمت آنها، پردازندههای گرافیکی فردا همچنان مرزهای طراحی تراشه VLSI و ساخت ریزپردازنده را جابجا میکنند. قابلیتهای خام پردازندههای گرافیکی آینده از نظر توان عملیاتی FP32 و پهنای باند داخلی به سطوحی میرسند که شاید اگر به یکی از افراد این صنعت در 10 سال پیش گفته میشد، او باور نمیکرد!

و با توجه به اینکه اینتل و سایرین مصمم هستند وارد بازار شوند و از رشد GPGPU در هوش مصنوعی بهره ببرند، میتوانیم از یک چیز مطمئن باشیم: AMD، Nvidia و بقیه شرکتهای مطرح در این بازار پر سود هنوز سالها تا رسیدن به آنچه واقعا میتواند انتهای مسیر نام بگیرد فاصله دارند. آنها می توانند با پردازندههای گرافیکی خود به موفقیت برسند و عطش طیف عظیمی از گیمرها را برای تجربه بازیها در بالاترین وضوح تصویر و کیفیت بصری نیز سیراب کنند.

شما از چه کارت گرافیکی استفاده میکنید؟ محضولات کدام یک از دو شرکت انویدیا یا AMD را بهترین گزینه برای بازی میدانید؟ نظرات خود را با به اشتراک بگذارید.

بیشتر بخوانید:

- کارت گرافیکهای NVIDIA در برابر ATI

- نقد و بررسی کارت گرافیک Nvidia GeForce RTX 3070 Ti

- آموزش مرحله به مرحله نصب کارت گرافیک

- نقد و بررسی کارت گرافیک AMD Radeon RX 6900 XT

برای ارسال دیدگاه ابتدا باید وارد شوید.